Trí tuệ nhân tạo: 'Kẻ kiểm duyệt toàn năng' của Facebook

Gã khổng lồ mạng xã hội Facebook không ngại đổ tiền vào trí tuệ nhân tạo nhằm biến công nghệ này thành người kiểm duyệt toàn năng.

Ra đời vào năm 2004, Facebook hiện nay đã có hơn 2,7 tỷ người truy cập hàng tháng và được mệnh danh là “ông hoàng truyền thông xã hội” khi mang đến trải nghiệm kết nối mạnh mẽ chưa từng có. Tuy nhiên, thời kỳ hoàng kim của công ty không thể kéo dài mãi - từ năm 2017, người dùng mạng xã hội bắt đầu cảm thấy bản thân bị đầu độc bởi những thông tin sai lệch, bình luận công kích.

Hàng loạt nội dung tiêu cực độc hại từ clip bạo hành, buôn trẻ em đến “phốt to” can thiệp vào chính trị giúp ông Trump giành được chức tổng thống Hoa Kỳ, Facebook dường như trở nên “sa đọa” hơn bao giờ hết. Ngay cả với những nỗ lực kiểm duyệt cũng không hoàn toàn giúp thông tin đến người dùng an toàn hơn. Do đó, Facebook quyết định “chọn mặt gửi vàng” đầu tư cho trí tuệ nhân tạo (AI) để cứu lấy danh tiếng đang tụt dốc.

CEO Mark Zuckerberg của Facebook tại Quốc hội Mỹ. Ảnh: AP Photo/Andrew Harnik.

Hệ thống tinh vi của AI có thể nhận biết đâu là nội dung độc hại và đem đi kiểm duyệt. Nhờ đó, trong quý 2 năm nay, Facebook báo cáo rằng họ đã gỡ bỏ 104,6 triệu mẩu nội dung (không bao gồm spam) vi phạm các tiêu chuẩn cộng đồng, loại bỏ 22,5 triệu bài viết công kích so với 9,6 triệu bài trong quý 1 và 2,5 triệu bài vào 2 năm trước.

Nhưng tương lai của Facebook là hình ảnh và đa phương tiện. Nội dung công kích, sỉ nhục có thể nằm ẩn trong video hoặc được mã hóa, trong những hình ảnh tưởng chừng chỉ mang tính hài hước. Đáng buồn thay, những đột phá mà công ty đã thể hiện qua ngôn ngữ tự nhiên AI đến nay chưa thể tiến bộ tới mức có thể nhận biết, phát hiện những thông tin độc hại ẩn khuất dưới vỏ bọc “giải trí lành mạnh”.

Hệ thống AI hoàn toàn mới

Thành công gần đây của Facebook trong việc phát hiện ngôn từ kích động 2 năm qua bắt nguồn từ một số bước đột phá mạnh mẽ của cộng đồng nghiên cứu trí tuệ nhân tạo.

Hầu hết các mô hình trí tuệ nhân tạo trước đây đã được tạo ra bằng cách Supervised Learning - đào tạo cho máy sử dụng dữ liệu được chỉ định nhờ mạng noron nhân tạo (mô hình toán học dựa trên các mạng noron thần kinh sinh học).

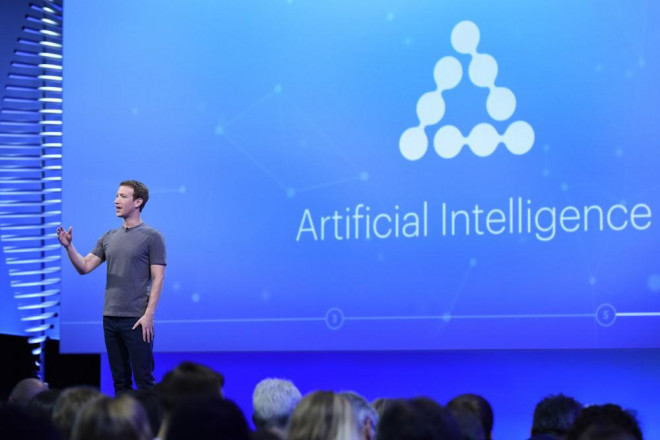

Ông chủ Facebook giới thiệu trí tuệ nhân tạo của công ty cho giới công nghệ. Ảnh: Bloomberg via Getty Images.

Điều này có nghĩa là số dữ liệu đó đã được quy định cho một câu trả lời đúng duy nhất, tương tự với việc một người đang tự học nhưng có sự giám sát của giáo viên. Nhược điểm của phương pháp này đó là không linh hoạt và nó sẽ loại bỏ những nội dung không nằm trong dữ liệu vì hiểu sai ngữ cảnh.

Nhưng Facebook hiện nay đang hướng tới một cách tiếp cận trí tuệ nhân tạo khác được gọi là Self-supervised Learning, cho phép AI trở nên linh hoạt hơn với nhiều tình tình huống và hiểu các sự vật theo mối tương quan như cách con người học tập từ lúc nhỏ đến trưởng thành.

AI được cung cấp một lượng lớn dữ liệu đào tạo không được gán sẵn giá trị - chẳng hạn như toàn bộ quyển sách, video dài hoặc hàng đống hình ảnh. Sau đó, các nhà khoa học sẽ điều chỉnh các tham số sao cho tỷ lệ AI nhận ra các nội dung độc hại bị ẩn cao hơn. Thật vậy, hệ thống không dùng giá trị do con người gán lên mà dùng phần ẩn của dữ liệu như một tín hiệu để hướng dẫn việc điều chỉnh các tham số.

Năm 2018, các nhà nghiên cứu của Google đã tạo ra một mô hình ngôn ngữ tự nhiên có tên BERT đạt nhiều thành công to lớn. Mô hình này được “dạy” một lượng lớn văn bản (11.038 cuốn sách và 2,5 tỷ từ trong các mục Wikipedia tiếng Anh), cùng với các phần của văn bản bị ẩn. Trong quá trình đào tạo, hệ thống dần dần tự điều chỉnh để điền chính xác vào các chỗ trống với xác suất đúng cao.

Những đại gia công nghệ không ngừng tung ra sản phẩm trí tuệ nhân tạo tối ưu cả về kỹ năng lẫn hiệu suất.

Vào năm 2019, Facebook đã xây dựng mô hình RoBERTa, dựa trên nền tảng của BERT cho mạng xã hội của mình, nhưng sử dụng nhiều dữ liệu đào tạo hơn. Nhà khoa học AI trưởng của Facebook Yann LeCun, một huyền thoại trong lĩnh vực AI chỉ ra thách thức: “Hệ thống phải hiểu được ý nghĩa thật sự của những từ ngữ được đặt trong cấu trúc câu và ngữ cảnh”.

Kết quả, nhờ ứng dụng mô hình mới, AI của Facebook đã ngay lập tức phát hiện 95% bài đăng kích động thù địch, tăng từ 88% được báo cáo vào tháng 4 và tăng từ 52% mà công ty đã báo cáo vào mùa hè năm ngoái.

Dạy AI “bắt trend” như người

Vì những kẻ xấu trên Facebook luôn nghĩ cách luồn lách tránh tai mắt kiểm duyệt, thông qua nhiều hình thức độc hại mới, công ty buộc phải đào tạo cho mô hình trí tuệ nhân tạo những nội dung, chủ đề được cập nhật thường xuyên, ví dụ gần đây là Covid-19.

Dữ liệu sẽ được cập nhật một phần nhờ người kiểm duyệt Facebook, những người trực tiếp thấy bài đăng độc hại gây hiểu lầm. Họ cũng có thể sử dụng công cụ AI để tìm kiếm và tiêu diệt các loại nội dung xấu đã từng tràn lan trên mạng. Khả năng này cũng biến người dùng trở thành lực lượng kiểm duyệt trực tiếp ngăn chặn các thành phần xấu trên mạng xã hội. Ngoài ra, mô hình cũng học hỏi từ các dữ liệu bị Facebook gỡ nhầm.

Facebook xóa hàng triệu bài đăng vì thông tin sai về Covid-19.

Tuy vậy, Mike Schroepfer - CTO của Facebook, thừa nhận rằng AI của công ty còn lâu mới hoàn hảo. Theo người dùng báo cáo, hệ thống của công ty đã gắn cờ và chủ động xóa tỷ lệ cao các bài đăng có lời lẽ công kích nhắm vào người da trắng. Tuy nhiên, theo các tài liệu bị rò rỉ vào tháng 7 năm 2019 do NBC News thu được, tỷ lệ bài đăng thù ghét các nhóm người dễ tổn thương bị Facebook gỡ lại thấp hơn hẳn. Điều này chứng tỏ thực tế rằng công cụ nhân diện tự động của Facebook đã không hoạt động hiệu quả.

Tuy nhiên, mối lo ngại về thành kiến chủng tộc trong các thuật toán kiểm duyệt nội dung của Facebook vẫn tiếp tục trong các cộng đồng học thuật và dân quyền. Những người ủng hộ quyền dân sự cho rằng không chỉ các chính sách của Facebook không đi đủ xa trong việc thu thập nội dung gây thù hằn, họ còn khẳng định rằng công ty thực thi không đồng đều hoặc thậm chí không làm theo chính sách.

Thách thức trong kiểm duyệt ảnh

Mặc dù việc kiểm duyệt nội dung theo thuật toán của Facebook đã được cải thiện đáng kể kể từ năm 2019 nhờ mô hình RoBERTa, nhưng vẫn còn nhiều thách thức ở phía trước. Phương pháp học tập tự giám sát của RoBERTa gần như không hoạt động hiệu quả trước các mô hình AI thị giác máy tính được sử dụng để phát hiện hình ảnh độc hại.

Chuyên gia trí tuệ nhân tạo Yann LeCun của Facebook. Ảnh: Facebook.

Các nhà nghiên cứu tại Facebook và Google hiện đang làm việc để chuẩn bị trước các bộ phân loại hình ảnh bằng cách sử dụng một phương pháp được gọi là “học tập tương phản”. Điều này liên quan đến 2 mạng noron nhân tạo làm việc cùng nhau để quyết định xem hàng triệu cặp hình ảnh giống nhau hay khác nhau. Một cặp tương tự có thể là hai ảnh khác nhau của cùng một người hoặc hai ảnh của cùng một đối tượng, nhưng một ảnh bị xoay hoặc bị bóp méo.

Yann LeCun, nhà khoa học chuyên về AI của Facebook, cho biết nghiên cứu đã mang lại bộ phân loại hình ảnh đủ chính xác để vượt qua các tiêu chuẩn nhận dạng hình ảnh hiện tại, nhưng ông vẫn nghi ngờ tính hiệu quả của nó nếu chạy trong quy mô lớn. Đó là bởi vì không gian lý thuyết mà mạng phải tạo ra để chứa các biểu diễn số của điểm ảnh là quá lớn.

Dữ liệu trực quan khác hẳn và phức tạp hơn những gì mà mô hình BERT và RoBERTa có thể hiểu. Mỗi điểm ảnh thuộc tính mang giá trị tọa độ, màu sắc và cách kết hợp khác nhau và gần như vô tận. Khi số lượng hình ảnh ngày càng nhiều, không gian lý thuyết cần thiết để lập biểu đồ cho chúng sẽ tăng lên vô cùng lớn, đòi hỏi sức mạnh tính toán mạnh mẽ.

Những thuật toán và mô hình trí tuệ nhân tạo mới giúp Facebook đối diện tốt hơn với nhiều thách thức kiểm duyệt mới. Ảnh: Godruma/iStock.

LeCun hiện đang nghiên cứu một cách tiếp cận khác, và hy vọng hiệu quả hơn để cải thiện bộ phân loại hình ảnh. Giống như các mô hình xử lý ngôn ngữ tự nhiên, các mô hình thị giác máy tính hoạt động tốt hơn nhiều trong việc nhận dạng cụ thể nếu chúng được cung cấp trước dữ liệu hình ảnh. Nghiên cứu của ông còn tập trung vào các cách để giảm số lượng thuộc tính hình ảnh mà AI phải tập trung vào chỉ những thuộc tính thực sự quan trọng.

Dạy cho mô hình đưa ra suy luận là rào cản lớn nhất đối với ông trong việc nâng cao hiệu quả thị giác máy tính. Nhưng LeCun đang đánh cược rằng đó là một vấn đề có thể vượt qua và có thể là thành quả nghiên cứu lớn cuối cùng trong sự nghiệp kéo dài hàng thập kỷ của ông.

“Theo tôi, đây là tấm vé tới tương lai. Đó là những gì tôi đang làm, còn việc tôi đúng hay không thì tôi không thể nói vì tôi chưa có kết quả để chứng minh,” anh ấy nói.

Meme: Biểu tượng của kỷ nguyên mạng

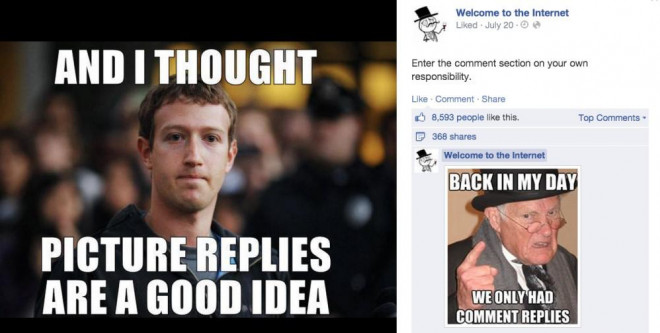

Bản chất đa phương thức của meme - sự kết hợp ngôn ngữ và hình ảnh - khiến chúng trở thành thách thức khó nhằn cho AI của Facebook. Meme thường mang tính ngữ cảnh cao, mang tính tham chiếu, mỉa mai và đầy sắc thái. Chúng cũng có thể được mã hóa khó hiểu để chỉ các thành viên của một số nhóm người dùng internet cụ thể mới có thể hiểu nghĩa.

Meme là một bài toán hóc búa đối với AI vì máy phải học từ nội dung của hình ảnh và nội dung của văn bản cùng một lúc chứ không thể hiểu một cách tách biệt. Do đó, tuy Facebook đã triển khai AI sử dụng phương pháp Supervised Learning để phát hiện nội dung đa phương thức độc hại, nhưng họ vẫn chưa biết cách xử lý một cách hiệu quả để giúp họ giải mã sự phức tạp và sắc thái của meme.

Meme được “chắp cánh” từ Facebook và chính mạng xã hội này trở nên bất lực trước trào lưu.

Mặc dù Facebook sắp công bố thông tin chi tiết về tiến trình loại bỏ nội dung độc hại, nhưng công ty lại không minh bạch về mức độ thực sự của vấn đề. Báo cáo tỷ lệ phần trăm nội dung mà hệ thống AI của họ phát hiện và với phần trăm được người dùng báo cáo cũng chỉ là bề nổi của tảng băng nội dung độc hại trên nền tảng mạng xã hội này.

Vào ngày 5/8, Facebook đã xóa một bài đăng khỏi trang chính thức của Donald Trump có chứa một đoạn video nói rằng trẻ em “gần như miễn dịch” với virus corona. Theo CrowdTangle, video vi phạm các quy tắc thông tin sai lệch về virus corona của Facebook, đã tồn tại trong khoảng bốn giờ và có nửa triệu lượt xem.

Hệ thống AI của Facebook dường như không thể phát hiện ngay những tuyên bố để xóa các bài đăng. Không khó để tưởng tượng sự căm thù và các loại nội dung độc hại khác cũng được phân phát trong video và meme. Một mô hình AI tiên tiến hơn, có lẽ là một mô hình được đào tạo trước bằng cách sử dụng phương pháp học tự giám sát và được trang bị để phân tích hình ảnh và văn bản cùng một lúc, mới có thể nhận dạng được chúng.

Khối lượng nội dung khổng lồ khiến chính Facebook cảm thấy quá tải và cần sự hỗ trợ của máy móc. Ảnh: Rolling Stone.

Nhiều thách thức kiểm duyệt nội dung của Facebook đang ngay lập tức và khó khăn, chẳng hạn như các vấn đề về chủ động phát hiện thông tin sai lệch, tuyên truyền và thù địch. Mặc dù,Facebook được hưởng lợi rất nhiều từ những tiến bộ gần đây trong AI ngôn ngữ tự nhiên khi bắt đầu xây dựng BERT của Google, nhưng nó có giới hạn kiểm soát còn hẹp.

Đối với tất cả những tiến bộ đã đạt được, AI kiểm duyệt nội dung của Facebook chỉ mới bắt đầu tác động đến hiệu quả của công ty trong việc phát hiện nội dung vi phạm trong từng lĩnh vực nằm trong tiêu chuẩn cộng đồng của nó, chẳng hạn như thù địch, khủng bố và thông tin sai lệch. Thế nên, Facebook sẽ phải tiếp tục nỗ lực để phát triển ứng dụng của mình hơn nữa.

Nguồn: [Link nguồn]