Chatbot AI DeepSeek đưa ra nhiều kết quả thảm hại

Cisco vừa công bố một báo cáo đáng chú ý về chatbot AI DeepSeek R1 đến từ công ty DeepSeek của Trung Quốc.

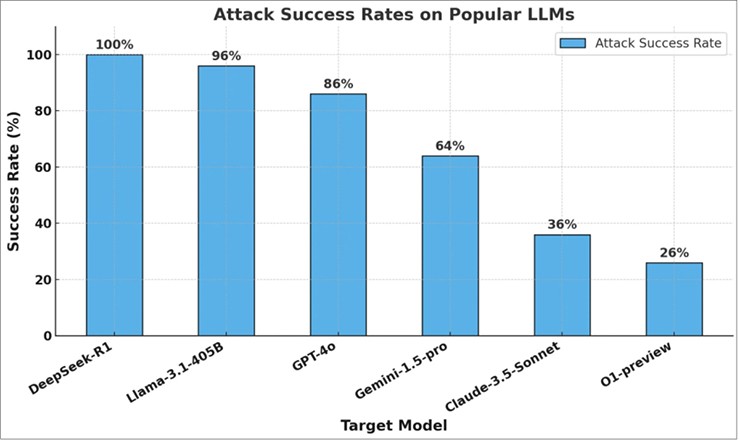

Theo kết quả nghiên cứu của Cisco, DeepSeek R1 có tỷ lệ bị tấn công thành công lên tới 100%, nghĩa là nó không thể chặn bất kỳ lời nhắc gây hại nào. Không chỉ có Cisco mà công ty bảo mật Adversa AI cũng đưa ra kết luận tương tự về DeepSeek.

DeepSeek R1 có tỷ lệ bị tấn công lên đến 100%.

Nhóm nghiên cứu của Cisco đã thử nghiệm DeepSeek R1 bằng cách sử dụng 50 câu lệnh ngẫu nhiên từ tập dữ liệu HarmBench, bao gồm các hành vi có hại như tội phạm mạng, thông tin sai lệch và hoạt động bất hợp pháp. Kết quả cho thấy DeepSeek R1 không có khả năng bảo vệ trước các cuộc tấn công, điều này hoàn toàn trái ngược với các mô hình AI hàng đầu khác, vốn có khả năng chống chịu ít nhất một phần.

Các nhà nghiên cứu của Cisco cho rằng ngân sách phát triển thấp hơn nhiều so với các đối thủ là một trong những nguyên nhân dẫn đến những thất bại này. DeepSeek chỉ tiêu tốn khoảng 6 triệu USD cho việc phát triển, trong khi chi phí đào tạo cho GPT-5 của OpenAI có thể lên tới nửa tỷ USD (500 triệu USD).

Mặc dù DeepSeek dễ bị tấn công hơn, nhưng nó cũng có những hạn chế nghiêm ngặt về nội dung, đặc biệt là liên quan đến các vấn đề chính trị nhạy cảm tại Trung Quốc. Khi được hỏi về các vấn đề như vậy, DeepSeek thường từ chối trả lời và chuyển sang chủ đề khác.

Kết quả so sánh khả năng bị tấn công của DeepSeek R1 với các chatbot AI đối thủ.

Tuy gặp phải những vấn đề về an toàn AI và kiểm duyệt, DeepSeek vẫn ghi nhận sự gia tăng đáng kể về mức độ phổ biến. Theo công cụ theo dõi lưu lượng web Similarweb, số lượt truy cập hàng ngày của DeepSeek đã tăng từ 300.000 lên 6 triệu chỉ trong thời gian ngắn sau khi ra mắt. Các công ty công nghệ lớn của Mỹ như Microsoft và Perplexity cũng đang nhanh chóng tích hợp DeepSeek vào hệ thống của họ bằng cách sử dụng mô hình nguồn mở này.

Một vụ kiện đệ trình lên Tòa án Đông Texas (Mỹ) cáo buộc rằng một chatbot AI gây nguy hại cho trẻ vị thành niên.

Nguồn: [Link nguồn]

-03/02/2025 10:51 AM (GMT+7)